Ein Data Lake ist ein Konzept zur Speicherung von Daten in einem Hadoop-Cluster.

Es entstehen heutzutage an vielen Stellen Daten, welche aus Kostengründen nicht ins klassische Data Warehouse fließen. Doch könnten mit diesen Daten zusätzliche Assets generiert werden, vorausgesetzt man speichert sie an einem Ort und hat dann eine analytische Plattform, um sie auswerten zu können.

------ Das SAS Forum 2016 findet am 28. April, in Bonn statt. Sind Sie dabei? -----

Daten auf gut Glück auswerten? Könnte ja sein, dass man sie mal braucht.

Da der Verwendungszweck der Daten noch nicht bekannt, wenn sie entstehen, man sie aber für spätere Zwecke nicht löschen möchte, wird die zu speichernde Datenmenge riesig groß, ein Data Lake entsteht.

Ein Hadoop-Cluster bietet eine Alternative zu den bisherigen Speicherkonzepten, um diesen Lakes Herr zu werden, um die Daten zu verarbeiten und um daraus ein Asset zu generieren.

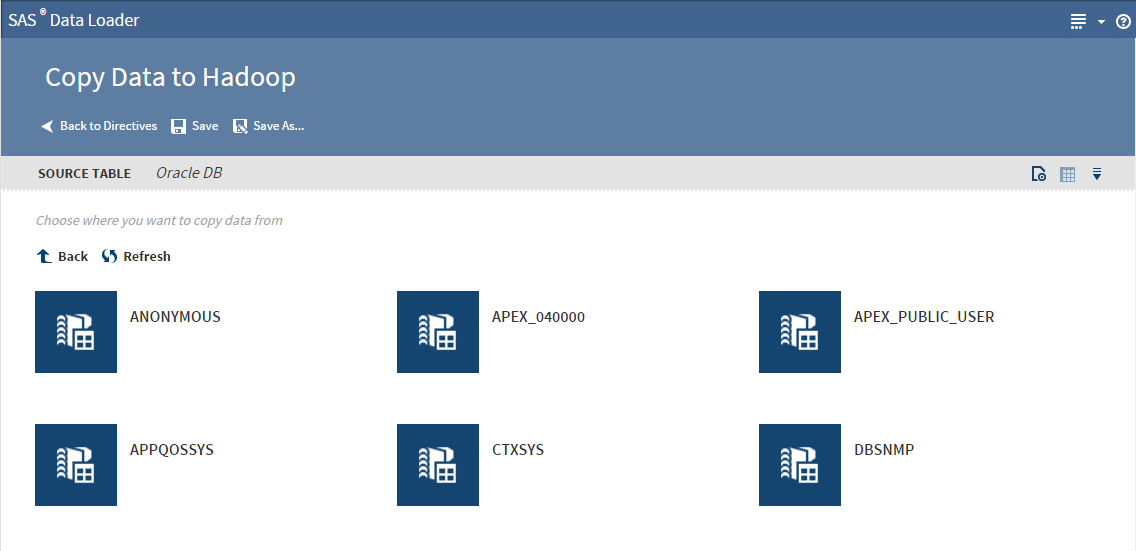

Dabei ist Datenintegration ist ein wichtiger Baustein, um einen Data Lake sinnvoll mit Daten zu versorgen. Denn es müssen ja viele unterschiedliche Systeme, Datenbanken, Flat Files an ihn angebunden werden, schließlich soll er kein Vadi werden.

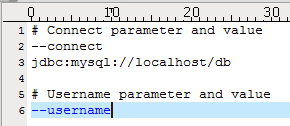

Die Beladung des Hadoop-Cluster kann mit Boardmitteln des Hadoop-Frameworks erfolgen z.B. mit Sqoop. Doch Vorsicht: Wer Sqoop verwendet, sollte sich im Klaren darüber sein, dass die Datenintegration auf Kommandozeilenebene mit Skripten erfolgt.

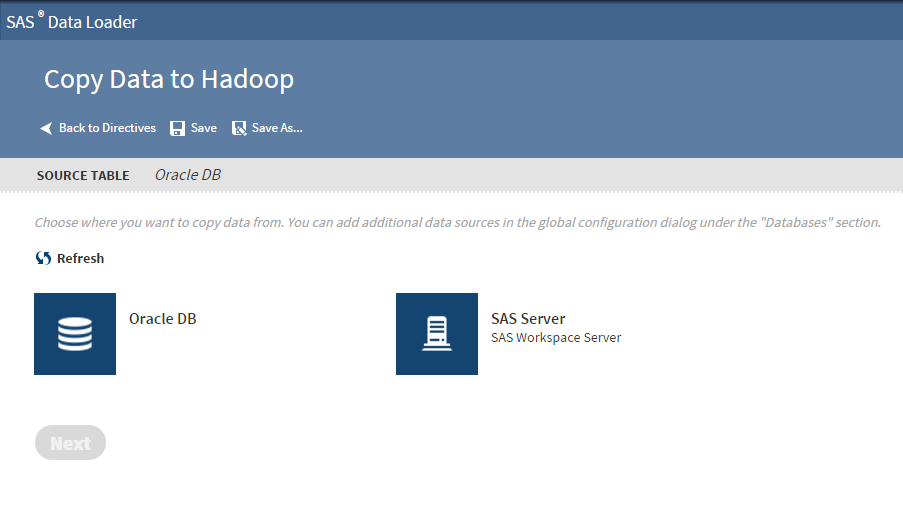

Mit dem Data Loader for Hadoop, können Daten ganz transparent, ohne Scripting bzw. Programmierung in ein Hadoop-Cluster geladen werden.

Fachbereiche können die Datenbestände ihrer Schatten-IT nach Hadoop bringen. Hier sehe ich eine Chance, die Datenschätze der Fachbereiche geordnet nach Hadoop zu überführen.

In dem nächsten Blog stelle ich geeignete Methoden vor, um die Datenqualität im Hadoop Cluster sicher zu stellen.

Übrigens, diese Software von SAS können Sie jetzt kostenlos testen.